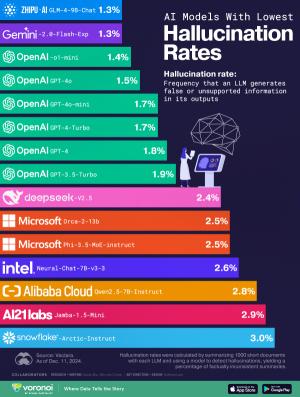

AI 기반 도구와 애플리케이션이 일상 생활에 더 많이 통합됨에 따라 모델이 때때로 잘못된 정보를 생성할 수 있다는 문제점이 점점 대두하고 있다.

IBM에서는 이러한 현상을 '할루시네이션(hallucinations)'이라고 하는데, 이는 생성형 AI 챗봇이나 컴퓨터 비전 도구와 같은 대규모 언어 모델(LLM)이 존재하지 않거나 인간이 인지할 수 없는 패턴이나 대상을 감지하여 부정확하거나 무의미한 결과를 산출할 때 발생하는 것으로 설명한다. 쉽게 말해, AI의 거짓말이다.

![[뉴스콕] 컵빙수 열풍에 매장 ‘비명’… 품절 대란·알바생](https://cdn.ibos.kr/design/upload_file/BD74667/THUMBNAIL_300_200_003f247048243a246039bc01ee350c66_86668_1.png)

아직 등록된 댓글이 없습니다.

cookiman님의 게시글에 첫번째 댓글을 남겨보세요.